Как использовать собственные API-ключи: Custom LLM Node и ИИ-агент

Это руководство описывает, как интегрировать любую OpenAI API-совместимую (LLM) модель в ваш рабочий процесс Nodul, включая self-hosted и сторонние сервисы. И Custom LLM Node, и AI Agent Node используют один и тот же метод подключения.

1. Настройка Custom LLM подключения

Механизм подключения основан на широко распространённой структуре OpenAI API, что позволяет использовать внешние сервисы (такие как Groq, Perplexity или Ollama), правильно указав Base URL.

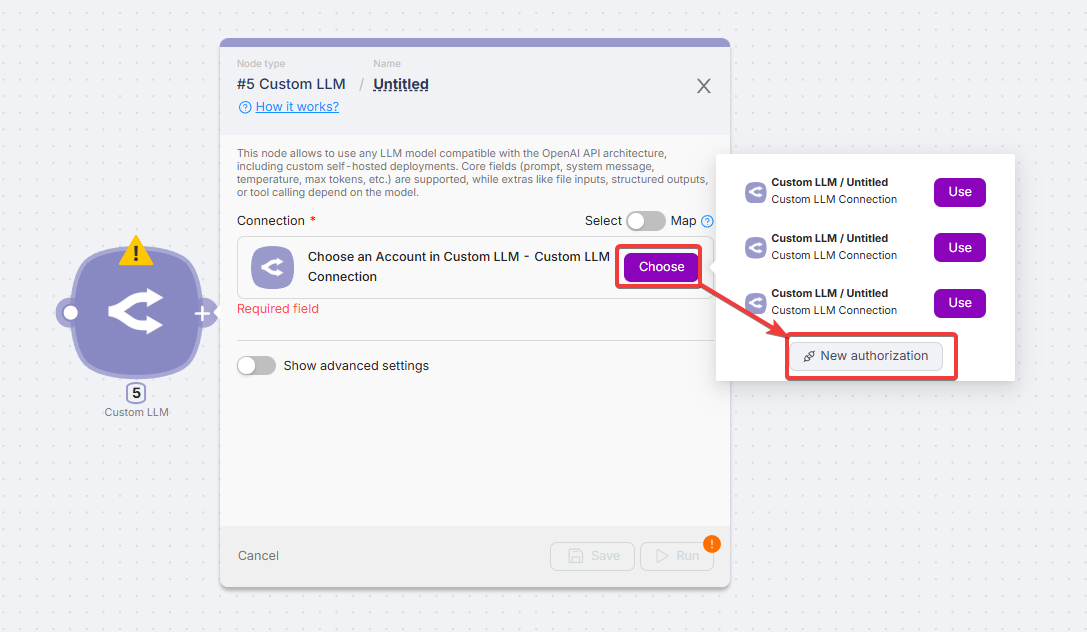

A. Создание новой авторизации

- Нажмите «Choose» и выберите «New authorization».

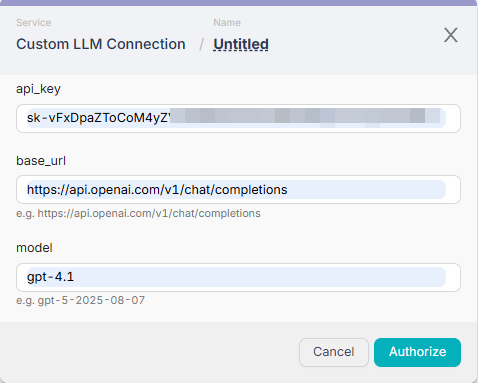

- Заполните данные подключения:

- API Key: Ваш секретный ключ, предоставленный LLM-сервисом.

- Base URL: URL-адрес эндпоинта, который принимает OpenAI-совместимые запросы chat completion. Это самое важное поле для совместимости.

- Model: Идентификатор модели (например,

gpt-4-turbo,llama-3).

Примеры совместимых Base URL:

| Сервис | Base URL |

|---|---|

| OpenAI | https://api.openai.com/v1/chat/completions |

| Groq | https://api.groq.com/openai/v1/chat/completions |

| Perplexity | https://api.perplexity.ai/chat/completions |

| Ollama (локально) | http://localhost:11434/v1/chat/completions |

| Azure OpenAI | https://[YOUR-RESOURCE].openai.azure.com/openai/deployments/[MODEL-NAME]/chat/completions?api-version=2024-02-15 |

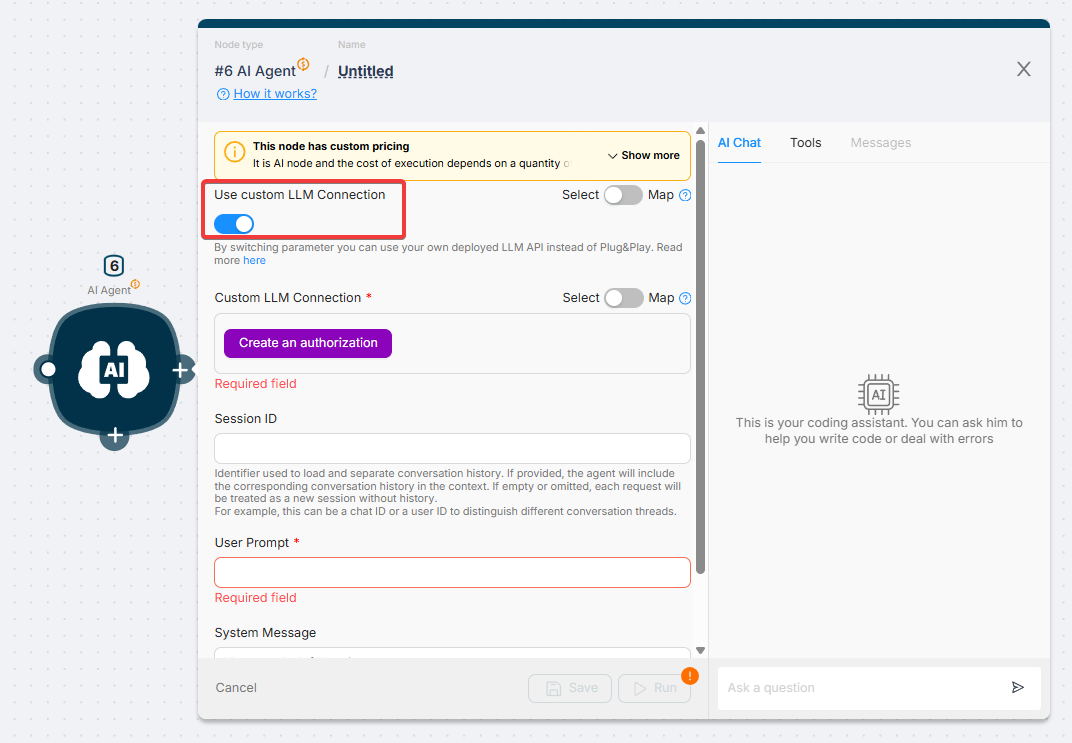

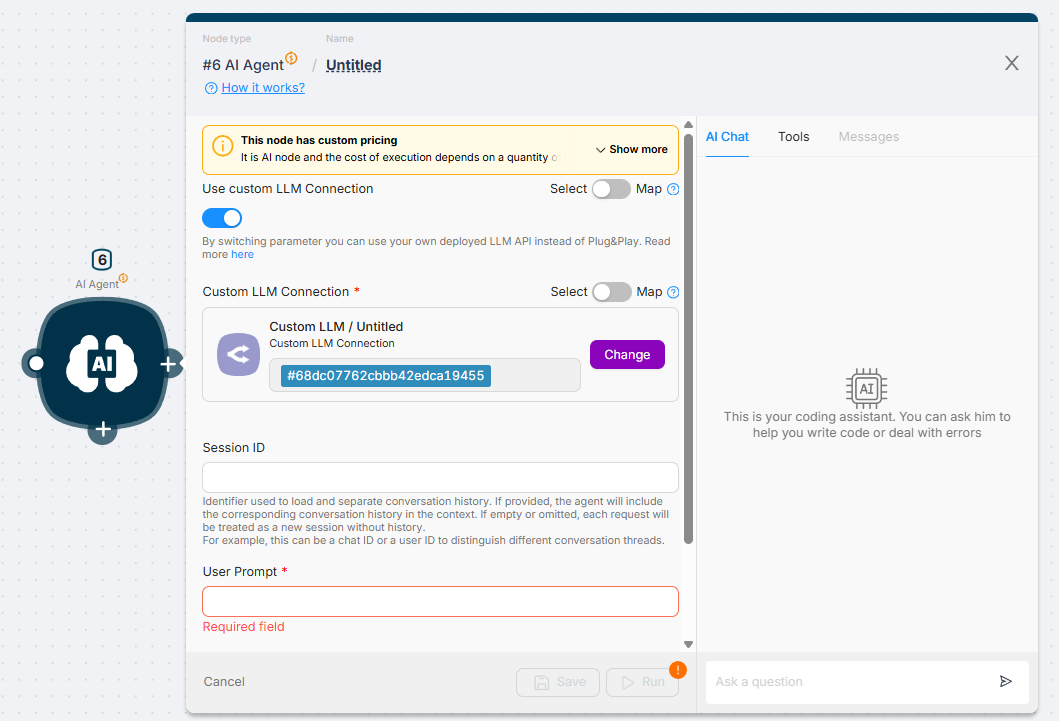

B. Использование подключения в AI Agent Node

Созданная авторизация доступна для повторного использования. Это позволяет использовать те же кастомные модели для ваших ИИ-агентов.

- В AI Agent Node переключите тумблер «Use Custom LLM Connection» в положение ON.

- Нажмите «Create an authorization».

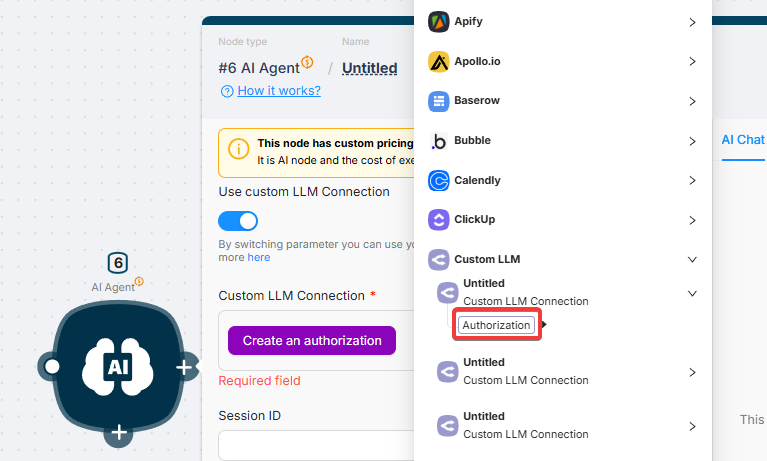

- Выберите ранее созданную авторизацию (и нажмите «Authorization», чтобы создать новую).

Ваша авторизация успешно добавлена.

2. Расширенные настройки: управление поведением LLM

Эти настройки находятся в разделе «Show advanced settings» в Custom LLM Node и обеспечивают детальный контроль над выводом модели, креативностью и управлением контекстом.

Параметры контекста и ввода

| Параметр | Описание | Применение |

|---|---|---|

| File Content | Принимает URL или переменную с данными файла. | Используется для мультимодальных моделей для анализа изображений или обработки не-изображений, таких как PDF (в сочетании с File Name). |

| File Name | Обязателен для не-изображений (текст, PDF, документы) при передаче данных через File Content. | |

| Dialog History JSON | Валидный JSON-массив с историей диалога ({"role": "user", "content": "..."}). | Необходим для поддержания контекста в многошаговых чат-ботах. |

Параметры генерации и креативности

Эти параметры контролируют качество и разнообразие генерируемого ответа. Рекомендуется настраивать либо Temperature, либо Top P, но не оба одновременно.

| Параметр | Описание | Эффект |

|---|---|---|

| Max Tokens | Максимальное количество токенов, которые модель может сгенерировать в ответе. | Контролирует длину ответа. |

| Temperature | Температура сэмплирования. Низкие значения (например, 0.1) дают более сфокусированный и детерминированный вывод. | Лучше для точных, фактических задач. |

| Top P | Параметр nucleus sampling. Низкие значения делают вывод более сфокусированным, ограничивая рассмотрение токенов малой вероятностной массой. | Альтернативный контроль разнообразия ответа. |

| Stop Sequences | Список токенов, при генерации которых модель немедленно прекращает вывод текста. | Используется для предотвращения продолжения модели после желаемой точки завершения. |

Структурирование и использование инструментов

| Параметр | Описание | Основная функция |

|---|---|---|

| Structured Output (Toggle) | Заставляет LLM отвечать в JSON-формате. | Идеально для надёжного извлечения данных в переменные. |

| Output JSON Schema | Валидная JSON Schema, определяющая точные поля, типы и обязательные свойства ожидаемого вывода. | Гарантирует структурированный, предсказуемый вывод для последующих узлов. |

| Tools JSON | JSON-объект, описывающий функции, которые модель может вызывать для выполнения запроса пользователя. | Включает возможности Function Calling или Tool Use продвинутых моделей. |

| Tool Choice JSON | Контролирует, какой инструмент (если есть) модель может вызвать (none, auto, required или конкретное имя функции). | Определяет действие модели при наличии инструментов. |

| Frequency Penalty | Снижает вероятность повторения токенов на основе их текущей частоты в тексте. | Препятствует повторению слов моделью. |

| Presence Penalty | Снижает вероятность повторного использования токенов, которые уже появлялись в контексте. | Поощряет модель вводить новые темы или концепции. |